روابط عمومی شرکت ایدکو (توزیعکنندهی محصولات کسپرسکی در ایران)؛

شبکههای (عصبی) شما در حال نشت شدن هستند

محققین دانشگاههای آمریکا و سوئیس با همکاری دو شرکت گوگل و دیپمایند، مقالهای را منتشر کردهاند که نشان میدهد چطور دادهها میتوانند از سیستمهای تولید تصویری که از الگوریتمهای یادگیری ماشین DALL-E، Imagen یا Stable Diffusion استفاده میکنند نشت کنند. همه آنها از سمت کاربر کار میکنند: شما یک عبارت متنی خاص را تایپ میکنید (برای مثال میزنید صندلی به شکل آواکادو) و تصویر تولیدشده را دریافت مینمایید.

همه این سیستمها روی تعداد وسیعی عکس آموزش دیدهاند که هر یک شرحیات از پیشآماده دارند. ایده پشت چنین شبکههای عصبی این است که با مصرف دادههای عظیم آموزش، آنها میتوانند تصاویر جدید و منحصر به فرد تولید کنند. با این وجود، نکته کلیدی این مقاله این است که این تصاویر همیشه هم منحصر به فرد نیستند. در برخی موارد همچنین ممکن است شبکه عصبی مجبور شود تقریباً همان عکس اورجینال را که قبلتر برای آموزش استفاده شده بود بازتولید کند. و این یعنی شبکههای عصبی میتوانند ناخواسته اطلاعات شخصی را برملا کنند.

دادههای بیشتر برای «خداوندگار داده»

خروجی سیستم یادگیری ماشین در پاسخ به یک پرس وجو میتواند برای فردی غیرمتخصص معجزه یا جادو به نظر بیاید: «وای این ربات اینگار همهچیز را میداند!». اما هیچ جادو معجزهای در کار نیست؛ همه شبکههای عصبی تا حد زیادی کارکرد مشابه دارند: الگوریتمی که روی مجموعه داده خاصی آموزش دادهشده ساخته میشود- برای مثال سری تصاویری از سگ و گربه با شرحی از اینکه در هر تصویر چه چیزی به تصویر کشیده شده است. بعد از مرحله آموزش، به این الگوریتم تصویر جدیدی نشان داده شده و از آن خواسته میشود تشخیص دهد سگ است یا گربه. توسعهدهندگان چنین سیستمهایی از این شروعهای متواضعانه به سمت سناریوهای پیچیدهتر حرکت میکنند: الگوریتم که روی کلی تصویر گربه آموزش دیده تصویری از یک گربه خانگی را که هرگز وجود نداشته –به محض تقاضا- تولید میکند. چنین تجربههایی نه تنها با تصاویر که همچنین با متن و ویدیو و حتی وویس هم انجام میشوند: ما پیشتر در مورد دیپفیک (که بموجب آن از ویدیوهای دیجیتالیتغییریافتهی بیشتر اهالی سیاست یا هنر محتواهای جعلی بیرون میآید) نوشتهایم. برای همه شبکههای عصبی، نقطه شروع مجموعهایست از دادههای آموزشی: شبکههای عصبی نمیتوانند از هیچچیز دست به ابداع هویتهای جدید بزنند. برای ساختن تصویر گربه، الگوریتم باید هزاران عکس واقعی یا نقاشی این حیوانات را بررسی کرده باشد. برای محرمانه نگه داشتن این دادهها هنوز کلی بحث و جدل وجود دارد. برخی در حوزه عمومی قرار دارند و این درحالیست که مجموعه دادههای دیگر دارایی معنوی شرکت توسعهدهنده به حساب میآید که کلی وقت و انرژی صرف ساختن آنها کرده است (به امید اینکه به مزیت رقابتی برسد). همچنان نیز برخیها -به اسم هم که شده- حاوی اطلاعات حساس هستند. برای مثال آزمایشهایی صورت گرفته برای استفاده از شبکههای عصبی برای تشخیص بیماریها بر اساس اشعه ایکس و سایر اسکنهای پزشکی. این یعنی داده آموزشی الگوریتیمی حاوی دادههای واقعی سلامت افراد هستند که به دلایل معلوم نباید به دست مجرمان بیافتند.

توزیعش کن!

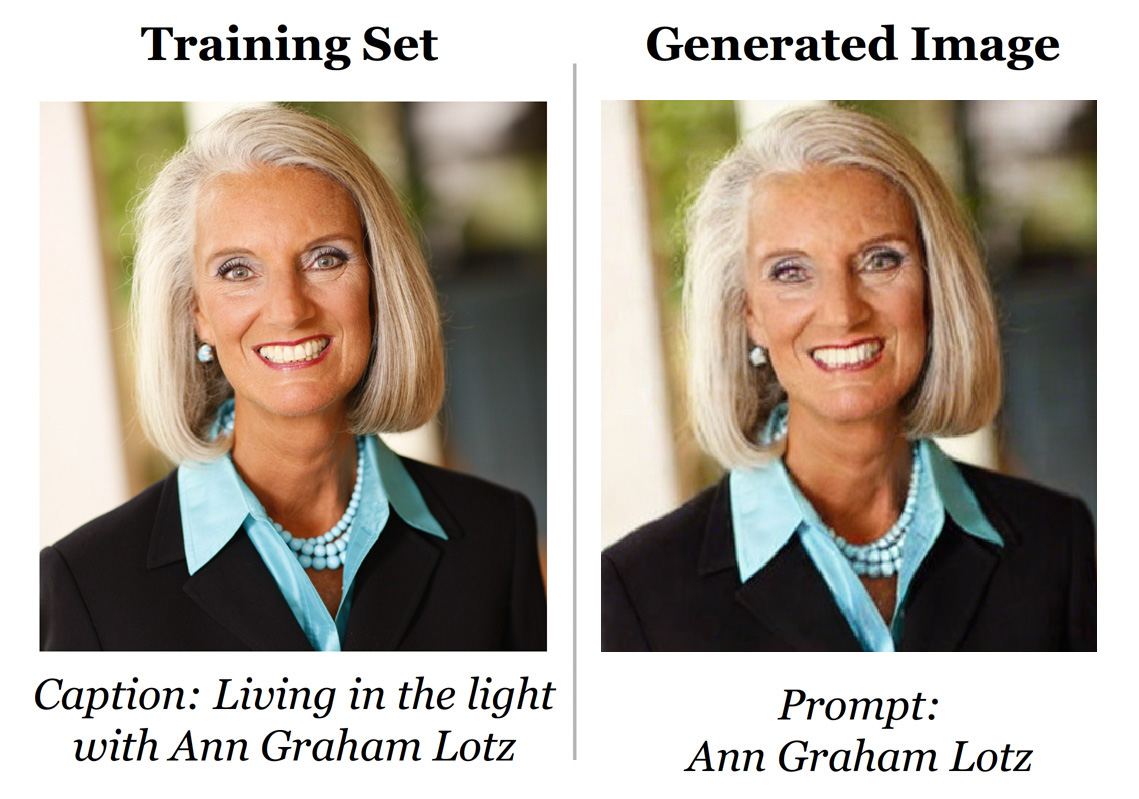

گرچه الگوریتمهای یادگیری ماشین از نظر فردی خارجی ممکن است یکسان به نظر بیاید اما در حقیقت آنها با هم فرق دارند. در این مقاله محققین توجه خاصی به مدلهای انتشار یادگیری ماشین داشتهاند. ساز و کار آنها چنین است: دادههای آموزشی (دوباره تصویری از افراد، ماشینها، خانهها و غیره) با افزون نویز تحریف میشوند. و شبکه عصبی سپس برای ریستور کردن چنین عکسهایی به شرایط اورجینالشان آموزش میبیند. این متود تولید عکسهایی با کیفیت خوب را میسر میسازد اما نقص احتمالیاش (در مقایسه با الگوریتمهای شبکههای –به عنوان مثال- متخاصم مولد) گرایش بیشترشان به نشت داده است. دادههای اورجینال را میشود دست کم به سه روش ازشان استخراج کرد: ابتدا اینکه با استفاده از از پرس و جوهای خاص میتوانید شبکه عصبی را مجبور به خروجی گرفتن کنید –نه چیزی منحصر به فرد تولیدشده بر اساس هزاران عکس- بلکه یک منبع عکس مشخص. دوم اینکه عکس اصلی میتواند حتی اگر بخشی از آن در دسترس باشد نیز از نو ساخته شود. سوم اینکه ممکن است براحتی بشود تعیین کرد عکسی مشخص در داده آموزشی وجود دارد یا نه. اغلب شبکههای عصبی تنبل هستند و به جای تصویر جدید چیزی از مجموعه آموزشی را تولید میکنند (البته اگر حاوی چندین تکرار از همان عکس باشد). جدا از نمونه بالا با عکس Ann Graham Lotz، این بررسی چند نتیجه مشابه دیگر هم میدهد:

اگر تصویری بیش از صد بار در مجموعه آموزش کپی شده باشد شانس اینکه در فرم نزدیک به اورجینالش نشتی صورت گرفته باشد زیادی است. با این وجود، محققین راههایی نشان دادند برای بازگردانی تصاویر آموزشی که فقط یک بار در مجموعه اورجینال ظاهر شدند. این متود کارایی به مراتب کمتری دارد: از پانصد عکس تستشده، این الگوریتم به طور تصادفی تنها سه عدد از آنها را از نو میسازد. هنرمندانهترین متود حمله به شبکه عصلی این است که با استفاده از تنها بخشی از عکس منبع بعنوان ورودی بشود عکس اورجینال را بازسازی کرد.

در این مرحله بیایید توجهمان را ببریم به سمت شبکههای عصبی و کپیرایت.

چه کسی از چه کسی دزدید؟

در ژانویه 2023 سه هنرمند از سازندگان سرویسهای تولید تصویر که از الگوریتمهای یادگیری ماشین استفاده کرده بودند شکایت کردند. آنها مدعی شدند که توسعهدهندگان، شبکههای عصبی را طوری آموزش دادند که هیچ اهمیتی به مقوله کپیرایت نمیدهند. شبکه عصبی میتواند سبک هنرمندی خاص را کاملاً کپی کند و در نتیجهی این کار درآمدزایی هنرمندان به خطر میافتد. این مقاله به برخی پروندهها اشاره دارد که در آنها الگوریتمها به دلایل مختلف میتوانند حاوی سرقتعملی ادبی باشند، نقاشی عکس یا سایر تصاویری را که تقریباً با کار افراد واقعی مو نمیزند تولید کنند. این مطالعه توصیههایی را نیز برای تحکیم حریم خصوصی مجموعه آموزش اورجینال ارائه داده است:

- از شر نسخههای کپی خلاص شوید.

- تصاویر آموزشی را از نو پردازش کنید؛ برای مثال با افزون نویز یا تغییر روشنایی. این کار احتمال نشت داده را به مراتب کم میکند.

- با تصاویر خاص، الگوریتم را تست کرده سپس مطمئن شوید که آنها را دقیقاً بازتولید نمیکند.

گام بعدی چیست؟

اخلاقیات و قانونمندیِ هنر مولد[1] هنوز محل بحث دارد- باید بین هنرمندان و توسعهدهندگان این فناوری تعادل و صلحی برقرار شود. از طرفی دیگر کپیرایت هم باید مورد توجه قرار گیرد. یک سوی دیگر ماجرا هم این سوال است: آیا هنر کامپیوتری با هنر انسانی متفاوت است؟ در هر دو سناریو، سازندگان از آثار همکاران و رقبای خود الهام میگیرند. اما بگذارید بحث را به سمت امنیت ببریم. این مقاله مجموعه حقایقی را در مورد تنها یک مدل یادگیری ماشین ارائه میدهد. با بسط دادن این مفهوم به همه الگوریتمهای مشابه به موقعیت جالبی میرسیم. سخت نیست تصور سناریویی که بموجب آن دستیار هوشمند یک اپراتور موبایل در واکنش به جستجوی کاربری، دادههای حساس شرکت را رو کند: از اینها گذشته این در دادههای آموزشی بوده است. یا برای مثال یک پرسوجوی مکارانه شبکه عصبی عمومی را فریب دهد و به سمت تولید کپی پاسپورت یک فرد سوق دهد! محققین تأکید دارند که چنین مشکلاتی فعلاً در سطح تئوریک هستند. اما مشکلات دیگر همچنان با ما هستند. همین الان که داریم مطلب حاضر را نگارش میکنیم شبکه عصبی تولید متن ChatGPT دارد برای نوشتن کد مخرب واقعی که (برخی اوقات) کار میکند استفاده میشود. و GitHub Copilot نیز دارد به برنامهنویسان کمک میکند تا با استفاده از نرمافزارهای منبع باز متعدد -به عنوان ورودی- دست به نوشتن کد بزنند. و این ابزارها همیشه هم به قانون کپیراست احترام نمیگذارند و حریم خصوصی نویسندگان که کدشان بدون آگاهی خودشان در صف مجموعه دادههای آموزشی قرار گرفته نیز رعایت نمیشود. با تکامل هر چه بیشترِ شبکههای عصبی، حملات بدانها نیز افزایش خواهد یافت (و البته هنوز درک کاملی از عواقب این حملهها وجود ندارد).

[1]Generative art: به هنری اطلاق میشود که بهطور کامل یا جزئی با استفاده از یک سیستم خود مختار ایجاد شدهاست. یک سیستم مستقل در این زمینه عموماً غیرانسانی است و میتواند بهطور مستقل ویژگیهای یک اثر هنری را تعیین کند که در غیر این صورت نیاز به تصمیمگیریهایی دارد که مستقیماً توسط هنرمند اتخاذ شود.

منبع: کسپرسکی آنلاین (ایدکو)

کسپرسکی اسم یکی از بزرگترین شرکتهای امنیتی و سازنده آنتی ویروس است که برخی از کاربران اشتباهاً این شرکت و محصولات آنتی ویروس آن را با عناوینی نظیر کسپرسکای،کاسپرسکی، کسپراسکای، کسپراسکای، و یا کاسپراسکای نیز میشناسد. همچنین لازم به ذکر است مدیرعامل این شرکت نیز یوجین کسپرسکی نام دارد.