روابط عمومی شرکت ایدکو (توزیع کننده محصولات کسپرسکی در ایران)؛ در رویداد امسالِ Kaspersky NEXT از پژوهش و مباحثات برجستهترین متخصصین اروپا در حوزهی امنیت سایبری و هوش مصنوعی پرده برداشته شد. در ادامه قصد داریم از فناوریهای هوش مصنوعی و یادگیری ماشین گرفته تا امنیتدهی به فناوری اینترنت اشیاء، به آنچه در رویداد سال جاری (14 اکتبر لیسبون) گذشت بپردازیم. پس ما را تا انتهای این مقاله همراهی کنید.

استفاده از فناوری هوش مصنوعی برای جهانی عادلانهتر

هیچ فکر کردهاید تا به حال ماشینها چه تعداد تصمیم گرفتهاند؟ و یا چه تعداد از این تصمیمها مبتنی بر مؤلفههایی چون جنسیت، نژاد یا پیشینه بوده است؟ احتمال میدهیم ندانید چقدر از تصمیمات به جای انسانها توسط هوش مصنوعی اتخاذ میشود. کریتی شارما، مؤسس شرکت AI for Good توضیح داد که همواره از الگوریتمها جهت تصمیمگیریهایی پیرامون اینکه ما که هستیم و چه میخواهیم استفاده میشود. کریتی همچنین اظهار داشت آنچه در نهایت، رشد و ارتقای هوش مصنوعی را موجب میشود این است که افرادی از پیشینه، نژاد و جنسیتهای مختلف را کنار هم گردآوریم. وی همچنین در تدتاکی به این موضوع اشاره کرد که چرا تعصب انسانی میتواند روی تصمیمگیری ماشینها تأثیر بگذارد.

تأثیر تعیین جنسیت در هوش مصنوعی

نگاهی به الکسا، سیری یا کورتانا بیاندازید. وجه مشترک بین این دستگاههای دیجیتالی چیست؟ آنها هر سه از صدای زن استفاده کرده و طوری طراحی شدهاند که فرمانبردار باشند. دلیلش چیست؟ آیا تکنولوژی دارد به کلیشهها دامن میزند و ریشههایشان را قویتر میکند؟ در این رویداد دو میزگرد با محوریت بررسی جنسیت و هوش مصنوعی تشکیل شد. دستیارهای دیجیتال، صدایی زنانه دارند چون (آنطور که مطالعات مختلف نشان میدهد) افراد با صدای زنانه برای دستیارهای دیجیتال بیشتر احساس راحتی میکنند. آیا این خود میتواند انعکاسی از جامعه باشد؟ بنابراین چطور میشود با نابرابریِ جنسیتی در فناوری هوش مصنوعی مبارزه کرد؟ شاید تولید صدایی خنثی در برابر جنسیت یا ساخت جنسیت برای رباتها و هوش مصنوعی فکر بدی نباشد، نظرتان چیست؟ علاوه بر پرداختن به این موضوع، همچنین داشتن تیمهایی متنوعتر برای ساخت فناوری هوش مصنوعی نیز اهمیت دارد؛ بدینترتیب میتوان شاهد برآیند وسیعتری از کاربرانی که AI به آنها خدمت میرساند بود.

«برای دستیار دیجیتال خود چه صدایی را ترجیح میدهید؟»

#Siri #Alexa #Cortana #KasperskyNEXT

- کسپرسکی (@kaspersky)14 اکتبر، 2019

افراد به رباتها بیشتر اعتماد دارند تا به انسانها

یک ربات اجتماعی در حقیقت سیستم مجهز به فناوری هوش مصنوعی است که با انسانها وسایر رباتها تعامل کرده و بر خلاف سیری یا کورتانا حضوری فیزیکی نیز دارد. تونی بالپائمه، استاد علم رباتیک در دانشگاه خنت توضیح داد که چطور با رواج استفاده از رباتها، موضوع تعاملات بین انسان و ربات نیز داغتر و جنجالیتر میشود. بالپائمه برخی از آزمایشات علمیای که او و تیمش انجام دادهاند را در طی این رویداد شرح داد. برای مثال، آنها توانایی انسانها در مقابل رباتها را آزمایش کردند تا به اطلاعات حساسی (تاریخ تولد، محل دوران کودکی، رنگ مورد علاقه و غیره) دست یافته و بتوانند از این اطلاعات برای ریست کردن رمزهای عبور استفاده کنند. جالب اینکه رباتها بیشتر از انسانها مورد اعتماد انسانها هستند؛ بنابراین افراد به رباتها راحتتر اطلاعات حساسشان را میدهند تا به آدمهایی از جنس خودشان. وی همچنین آزمایشی از نفوذ فیزیکی نشان داد. گروهی از افراد که موظف شده بودند امنیت ساختمان یا محلهای را حفظ کنند براحتی گذاشتند یک ربات وارد محل یا آن ساختمان شود. هیچ دلیلی ندارد فکر کنیم رباتها قابلاعتماد و امنند؛ اما انسانها همیشه فکر میکنند رباتها سازههایی بیآزارند (همین احساس است که آنها را مستعد اکسپلویت کردن میکند).

آیا افراد بزرگسال نیز تحت تأثیر رباتها قرار میگیرند؟

آزمایش: دسترسی به محلهای ممنوعه با روشهای مختلف

تلاش بعدی: رباتهای پیتزا به دست به موفقیت 100% رسیدند

@TonyBelpaema در KasperskyNEXT pic.twitter.com/h79Ssz0Crp#

- کسپرسکی (@kaspersky)14 اکتبر، 2019

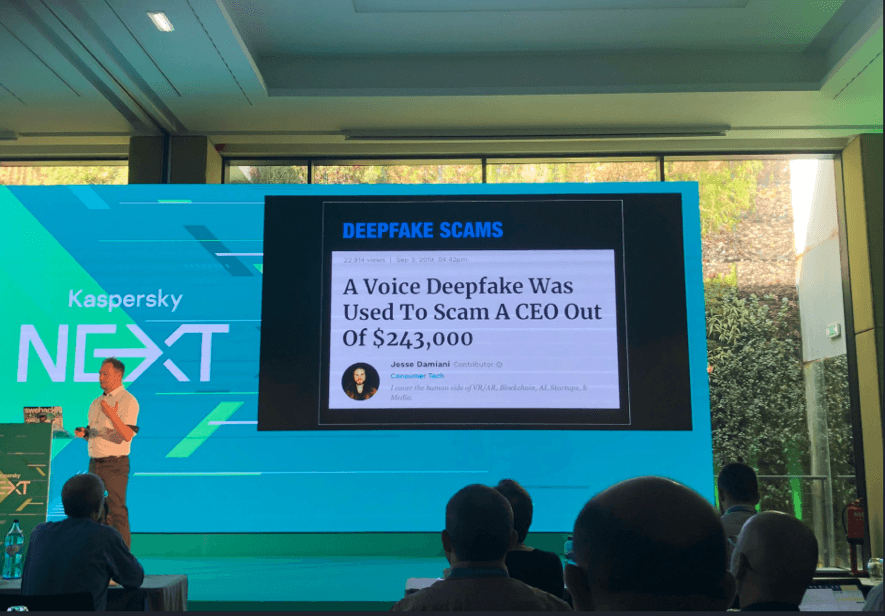

هوش مصنوعی، جعلهای عمیقِ[1] (دیپ فیک) بسیار واقعی خواهد ساخت

دیوید یاکوبی، یکی از اعضای Kaspersky GReAT در مورد مهندسی اجتماعی: چتباتها، هوش مصنوعی و تهدیدات خودکار صحبت کرد. اپها با شناسایی زمان، چهره و صدا میتوانند از طریق مهندسی اجتماعی یا سایر متودهای قدیمی مورد اکسپلویت قرار بگیرند. یاکوبی همچنین از دیپفیک گفت، ترفند جعل عمیق که شناساییاش بسی سختتر شده است. اینکه چطور ممکن است این ترفند در آینده روی انتخابات و برادکستهای خبری تأثیر بگذارد خود، دغدغهایست بس بزرگ. با این حال، نگرانی اصلی، موضوع «اعتماد» است. وقتی فناوریای کامل میشود به چه کسی اعتماد خواهید کرد؟ راهحل او، آگاهیِ بیشتر بود: آموزش و نیز فناوری جدیدی که بتواند به کاربران کمک کند ویدیوهای جعلی را شناسایی کنند.

امنیت در علم رباتیک

دمتری گالوو، یکی دیگر از اعضای Kaspersky GReAT در مورد ROS (سیستمعامل ربات) صحبت کرد؛ فریمورکی انعطافپذیر برای نوشتن نرمافزار ربات. ROS مانند خیلی از سیستمهای دیگر با تمرکز روی مؤلفهی امنیت طراحی نشده است و شاید مشکل امنیتی زیادی هم داشته باشد. سازندگان قبل از محصولات مبتنی بر ROS مانند رباتهای اجتماعی و خودروهای خودمختار میبایست ابتدا به این مسائل بپردازند. البته شکی نیست که نسخهی جدید ROS دارد شدیداً پیشرفت میکند.

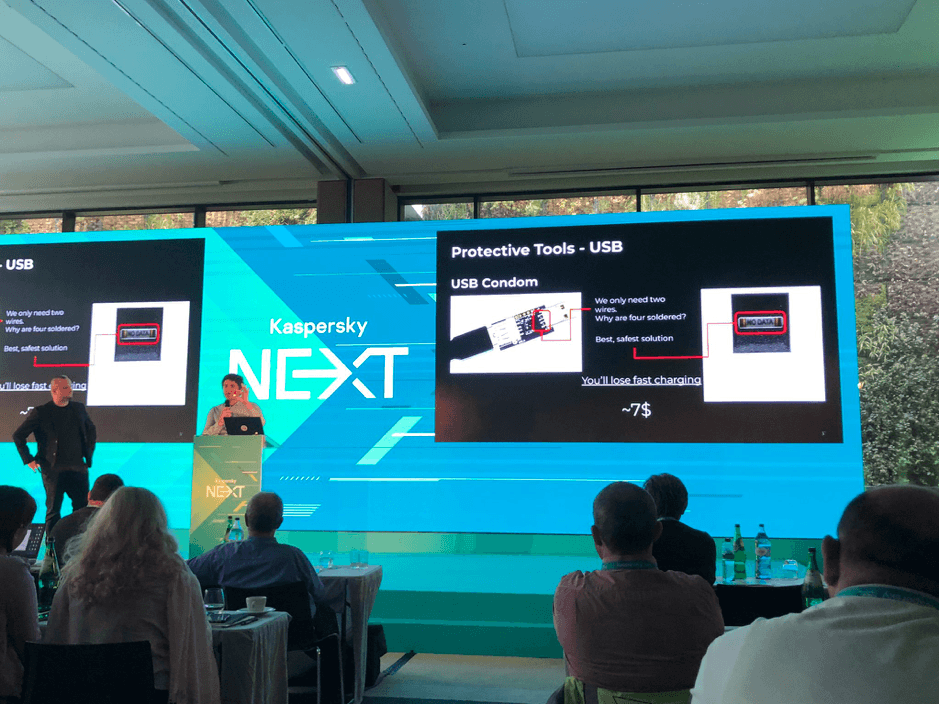

توصیه: از پوشش یواسبی استفاده کنید

مارکو پروس و دان دمتر، اعضای Kaspersky’s GreAT از نحوهی مراقبت افراد از خود در مقابل هک حین سفرهای کاری سخن گفتند. تا به حال فکرتان به این رفته است که شاید وقتی برای کار به سفر رفتید در هتلتان دوربینهای مخفی یا آینههای دوطرفه کار گذاشته باشند؟

این دو از اهمیت پوشش یواسبی صحبت کردند: اگر میخواهید با استفاده از پورت ناشناس یواسبی گوشی خود را شارژ کنید، بهتر است دستگاه خود را با استفاده از این گجت کوچک محافظت نمایید. خوشبختانه، این پوششها قابلیت استفادهی مجدد نیز دارند.

[1] Deepfake، ترکیبی از کلمههای " یادگیری عمیق " و "جعلی"، یک تکنیک برای ترکیب تصویر انسان مبتنی بر هوش مصنوعی است.

منبع: کسپرسکی آنلاین (ایدکو)

کسپرسکی اسم یکی از بزرگترین شرکتهای امنیتی و سازنده آنتی ویروس است که برخی از کاربران اشتباهاً این شرکت و محصولات آنتی ویروس آن را با عناوینی نظیر کسپرسکای،کاسپرسکی، کسپراسکای، کسپراسکای، و یا کاسپراسکای نیز میشناسد. همچنین لازم به ذکر است مدیرعامل این شرکت نیز یوجین کسپرسکي نام دارد.